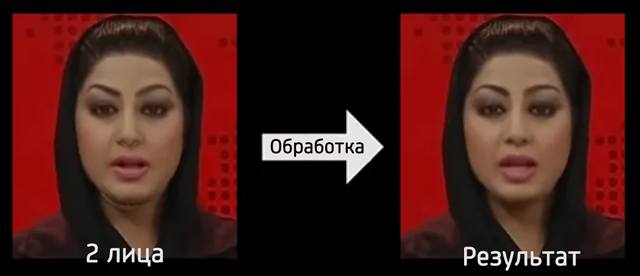

При достаточном количестве исходных изображений не так сложно превратить вашего соседа в известного политика. Поначалу выявлять дипфейки было не так уж сложно – даже самые лучшие из них имели визуальные проблемы, такие как размытие, искажения и сверхъестественные черты лица, из-за которых они просто казались нереальными.

Однако, это игра в кошки-мышки, и как только мы изучали один метод обнаружения дипфейков, следующее поколение исправляло ошибку. Есть ли какие-нибудь надежные решения, позволяющие выяснить, какие видео нас пытаются обмануть?

Дипфейк: визуальные подсказки обмана

Артефакты – это не просто вещи, которые Индиана Джонс помещает в музеи, – это ещё и небольшие отклонения, оставленные после обработки изображения или видео. В ранних дипфейках их часто можно было уловить человеческим глазом, а плохие дипфейки всё ещё могут иметь несколько предупреждающих знаков, таких как размытие по краям, чрезмерно сглаженное лицо, двойные брови, глюки или вообще ощущение «неестественного поведения лица».

Однако, эти методы сейчас улучшены до такой степени, что артефакты видны только другим алгоритмам, которые комбинируют видеоданные и исследуют вещи на уровне пикселей. Некоторые из них могут быть довольно креативными, например, одна техника проверяет, совпадает ли направление носа с направлением лица. Разница слишком тонка, чтобы люди обратили на неё внимание, но машины, как оказалось, неплохо справляются с этим.

Биометрические подсказки

Некоторое время казалось, что ключом к разоблачению дипфейков было отсутствие у них естественного моргания из-за относительной редкости исходных изображений с «закрытыми глазами». Однако, не потребовалось много времени, чтобы следующее поколение технологии deepfake «научилось моргать», что быстро снизило эффективность этой техники.

Другие биометрические индикаторы ещё не были полностью преодолены, например, индивидуальные особенности, которые алгоритмы не могут легко преобразовывать, потому что они требуют некоторого контекстного понимания. Маленькие привычки, такие как быстрое моргание, когда вы удивлены, или поднятие бровей, когда вы задаете вопрос, могут быть подхвачены и использованы дипфейком, но не обязательно в нужное время, поскольку они (пока) не могут автоматически определить, когда следует применять эти движения.

ИИ, способный считывать сердцебиение с помощью видеоизображений, имеет множество приложений, помимо обнаружения дипфейков, но поиск периодических движений и изменений цвета, которые сигнализируют о частоте сердечных сокращений, может помочь идентифицировать созданных самозванцев.

AI проекты

Многие громкие имена очень заинтересованы в решении проблемы дипфейков. Facebook, Google, Массачусетский технологический институт, Оксфорд, Беркли и множество других стартапов и исследователей решают эту проблему, обучая искусственный интеллект обнаруживать фальшивые видео, в том числе перечисленными выше методами.

Конечно, это работает только до определенного момента. Пока продолжают создавать дипфейки с использованием самых современных технологий, всегда будет небольшая задержка между обнаружением новейших уловок дипфейка и способностью этих алгоритмов их отловить.

Аутентификация: важная цель дипфейков

Технологии обнаружения не являются полным ответом на дипфейки, так как они, вероятно, никогда не будут иметь 100% успеха. Дипфейки, в которые было вложено время и деньги, смогут пройти множество тестов на сниффинг и обмануть ИИ. Ещё давайте вспомним, как работает Интернет: даже если эти подделки будут обнаружены, они все равно будут рециркулированы и в них поверит какая-то группа людей.

Вот почему также важно иметь какой-либо механизм проверки – какое-то доказательство того, какое видео является оригиналом, или что-то, что может указать, было ли изменено видео. Это то, что делают такие компании, как Factom, Ambervideo и Axiom, кодируя данные о видео в неизменяемые блокчейны.

Основная идея многих таких проектов заключается в том, что данные, содержащиеся в видеофайле или сгенерированные определенной камерой, могут использоваться для создания уникальной подписи, которая изменится, если видео будет изменено. В конце концов, видео, загруженные в социальные сети, могут иметь генерировать код аутентификации, который исходный загрузчик может зарегистрировать в блокчейне, чтобы доказать, что они являются первоначальными владельцами видео.

Эти решения, конечно, имеют свой собственный набор проблем, таких как кодирование видео, изменяющее данные в файле и изменение подписи без фактического изменения видеоконтента, или законное редактирование видео, искажающее подпись. Однако, в ситуациях с высокими ставками, таких как коммерческие транзакции, когда изображения используются для проверки доставки или получения поддержки инвестора, наличие такого уровня аутентификации может помочь предотвратить мошенничество, связанное с дипфейком.

Дипфейки опаснее фотошопа?

На данный момент мы все просто предполагаем, что изображения могут быть ненастоящими, потому что мы полностью осознаем, что существует технология, позволяющая сделать практически всё реалистичным на неподвижном изображении.

В конце концов, мы можем начать подходить к видео с таким же скептицизмом, поскольку подделка их становится такой же простой и убедительной, как редактирование изображения в Photoshop.

Однако, даже с учетом общей осведомленности легко представить себе множество реальных инцидентов, которые начнутся с своевременного высококачественного дипфейка в недалеком будущем.