Благодаря искусственному интеллекту нас ждёт прекрасное будущее, но его развитие вызывает много вопросов, и большинство из них касаются морали и этики.

Сильный и слабый искусственный интеллект

Сначала мы должны сказать о двух концепциях: сильного и слабого искусственного интеллекта. Сильный ИИ – это гипотетическая машина, которая способна мыслить самостоятельно и осознавать собственное существование. Может решать не только индивидуальные для неё задачи, но и изучать новые вещи.

Слабый ИИ уже существует. Это приложения, созданные для решения конкретных проблем, таких как распознавание образов, управление автомобилями, игра в го и т.д. Слабый искусственный интеллект мы часто называем «машинным обучением».

Мы ещё не знаем, сможем ли создать сильный искусственный интеллект. Однако, исследования, проведенные экспертами, показывают, что нам придётся ждать ещё 45 лет. Поэтому можно сказать, что «однажды» это случится.

Эксперты также утверждают, что термоядерная энергия станет коммерческой в течение 40 лет – точно так же они говорили 50 лет назад.

Главные дилеммы искусственного интеллекта

По-прежнему не известно, когда появится сильный AI. Однако, его слабый вариант мы используем во многих областях, и каждый год он вводится где-то в новом месте. Машинное обучение позволяет нам выполнять практические задания без традиционного программирования – учится на основе примеров.

Так как мы учим системы решению конкретных проблем, результирующая математическая модель – то, что мы называем алгоритмом – не может вдруг захотеть поработить (или спасти) человечество. Другими словами, нам не нужно бояться сценария с системой «Скайнет» в главной роли со стороны слабого искусственного интеллекта.

Однако, это не означает, что не существуют каких-либо проблем в этой теме.

Злые намерения

В прошлом году разразился небольшой скандал. Google решил создать программное обеспечение, используемое в военном проекте под названием Maven Project, в котором используются дроны. В будущем это может помочь в создании полностью независимых систем оружия.

В результате 12 сотрудников компании Google отказались участвовать в проекте, и ещё 4000 подписались под петицией, в которой требуют от компании разорвать контракт с армией.

Более 1000 известных ученых, работающих в области искусственного интеллекта, этики и IT, направили в Google открытое письмо, в котором просят компанию отказаться от реализации упомянутого проекта и поддержать международный договор, который запрещает разработку автономного оружия.

Ошибка программиста

Даже если программисты-разработчики алгоритмов машинного обучения не имеют злых намерений, многие из них хотят зарабатывать – поэтому их алгоритмы создаются для того, чтобы принести им пользу, а не для того, чтобы делать добро для общества. Некоторые медицинские алгоритмы могут рекомендовать дорогостоящие лечение вместо того, которое будет иметь лучший результат для конкретного пациента.

Иногда людей не интересует алгоритм, который должен служить примером морали. Например, существует зависимость между скоростью движения и уровнем смертности в автомобильных авариях. Мы могли бы запрограммировать автономные автомобили так, чтобы они двигались не быстрее чем 25 км/ч, что, вероятно, сведёт на нет гибель в дтп. Однако, это сопряжено с отказом от других преимуществ использования автомобиля.

Параметры системы не всегда учитывают этические вопросы

Компьютеры не имеют никакого понятия об этике. Например, некий алгоритм может быть использован для определения бюджета, в целях «максимизации ВВП/эффективности работы/продолжительности жизни», однако, если в модели не будут применяться этические ограничения, он может резко снизить бюджет школ, хосписов и организацией по защите окружающей среды, потому что они непосредственно не они увеличивают ВВП.

В более широкой перспективе такой алгоритм может принять решение об увеличении производительности труда путем увольнения людей, которые в силу физического состояния не достаточно производительны (например, лица предпенсионного возраста, инвалиды и т.д.).

Напрашиваются выводы, что этические вопросы следует учитывать с самого начала возникновения идеи.

Этика понятие относительное

Этика меняется с течением времени, иногда это происходит очень быстро. Например, подход к правам ЛГБТ-сообществ изменился за время жизни одного поколения.

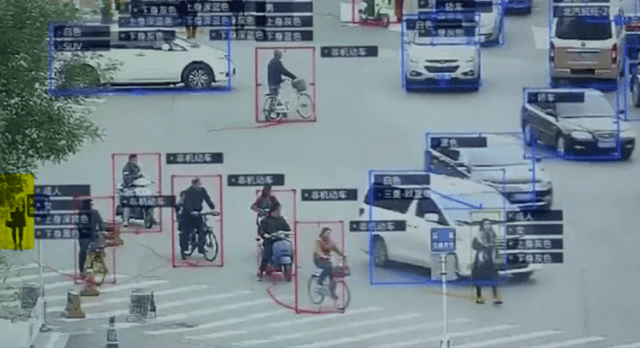

Этические принципы могут также отличаться в различных группах в пределах одной страны, не говоря уже о разных странах. Например, в Китае норма – это использование распознавания лиц для целей массового наблюдения. Остальные страны могут иметь совершенно другой подход к этому вопросу, и решение может зависеть от ситуации.

Значение имеет также политический климат. Например, борьба с терроризмом изменила во многих странах некоторые этические нормы и идеалы.

Машинное обучение меняет людей

Системы машинного обучения – всего один пример искусственного интеллекта, который имеет непосредственное влияние на людей – рекомендует новые фильмы на основе того, как пользователь оценил другие фильмы, а также учитывая предпочтения других пользователей. Некоторые системы работают неплохо.

Однако, с течением времени реферальная систему рекомендаций меняет чьи-то предпочтения и значительно сужает выбор. Если мы не используем этот механизм, то иногда попадаем на неудачные фильмы; искусственный интеллект предлагает только «проверенные» фильмы. В конце концов, пользователь перестаёт искать и полностью доверяется подсказкам.

Что интересно, мы даже не замечаем, когда алгоритмы, нами манипулируют. Пример, связанный с фильмами не страшен, но если мы перенесем эту схему на область информации и пропаганды...

Поддельные связи

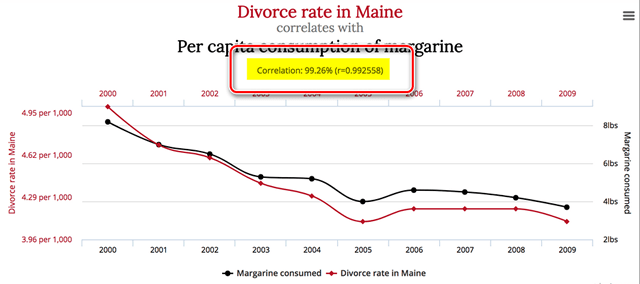

Поддельные связи возникают, когда полностью независимые друг от друга вещи показывают очень похожее поведение, это может создать впечатление, что они каким-то образом связаны друг с другом. Например, знали ли вы, что потребление маргарина в США сильно коррелирует с количеством разводов в штате Мэн?

Конечно, люди, основываясь на личном опыте и интеллекте, немедленно признают, что прямая связь между этими двумя аспектами очень маловероятна. Математической модели это безразлично – она только собирает и обобщает данные.

Хорошо известным примером является программа, которая назначает пациентам неотложную медицинскую помощь. Она решила, что пациенты с астмой, которые имели воспаление легких, не нуждались в помощи быстрее, чем пациенты с пневмонией, но без астмы. Эта программа анализировала данные и заметила, что пациенты с бронхиальной астмой были менее подвержены риску смерти, так что не должны рассматриваться в приоритетном порядке. На самом деле, процент смерти был ниже именно потому, что они всегда получали помощь в пунктах медицинской помощи, поскольку существовал высокий риск, связанные с их состоянием.

Причинно-следственные петли

Хуже ложной корреляции являются причинно-следственные петли. Здесь речь идёт о ситуациях, в которых решения, принимаемые алгоритмами, имеют последствия в реальном мире, что, в свою очередь, убеждает их, что они были правы.

Например, программа предотвращения преступлений в Калифорнии предположила, что полиция должна отправлять всё больше и больше людей в афро-американские районы из-за большого процента преступлений. Однако, большее число полицейских машин в районе привела к тому, что местные жители чаще сообщали о преступлениях. В результате офицеры писали больше протоколов и отчетов, что привело к увеличению коэффициента преступности

«Грязные» или «отравленные» данные

Эффекты обучения алгоритмов, в значительной степени, зависит от данных, на основе которых проводится обучение. Может оказаться, что эти данные были неверны и искажены, то ли случайно, то ли по чьему-то злому умыслу (в последнем случае это называется «отравлением» данных).

Если данные, используемые в качестве тренировочного образца для алгоритма, ответственного за найм людей, будут получены от компании, которая использует расистские практики, алгоритм также будет работать на принципах расизма. Именно так и возникают проблемы, источник которых лежит в данных.

Когда-то Microsoft создала чатбота в Twitter и любой человек мог поговорить с ним. Однако, компании пришлось отключить такую возможность менее чем через 24 часа, потому что «добрые» интернет-пользователи быстро научили бота ругаться и читать отрывки из книги «Моя борьба» авторства Адольфа Гитлера.

Это отличный пример отравления данных, используемых для машинного обучения. Математическая модель, используемая для анализа компьютерных вирусов, обрабатывает, в среднем, миллион файлов в день, как нейтральных, так и вредных. Из-за того, что ландшафт угроз постоянно меняется, изменения модели передаются на продукты, установленные на стороне клиента в виде обновления антивирусных баз данных.

К сожалению, хакер может генерировать вредоносные файлы очень похожие безобидные и отправлять их в антивирусную лабораторию. Такие действия постепенно стирают грань между безобидными и вредными файлами – в результате, модель может давать ложную тревогу.

Обман искусственного интеллекта

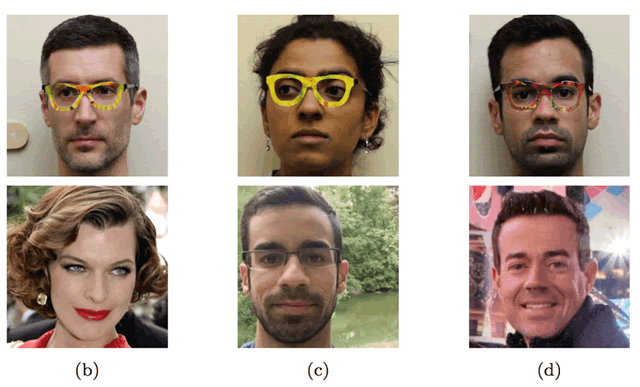

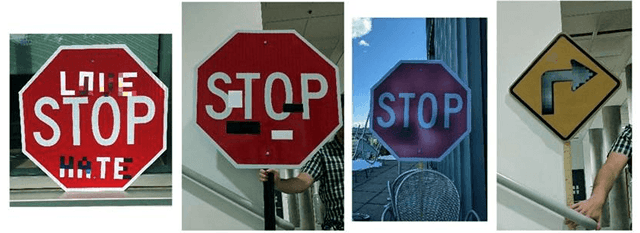

Даже хорошо работающая математическая модель – которая использует правильные данные – может быть обманута, если кто-то знает, как она работает. Например, группа исследователей раскусила, как можно обмануть алгоритм распознавания лица с помощью специальных очков, которые минимально искажают изображение, полностью меняя результат.

Надевая очки с правками в специальном цвете, исследователи обманули алгоритм распознавания лиц, который принимал их за кого-то другого.

Систему можно легко обмануть, даже в повседневных ситуациях, которые не являются особенно сложным.

Первые три символа были восприняты как знаки ограничения скорости до 45 км/ч, а последний как знак СТОП.

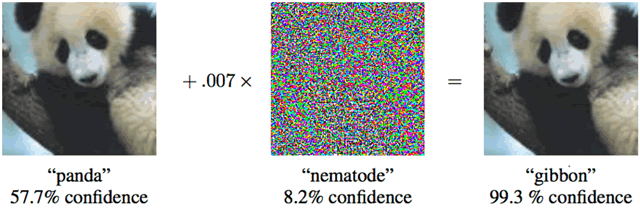

Более того, чтобы обмануть математическая модель машинного обучения, изменения не должны быть значительными – достаточно минимальных изменений, незаметных для глаз человека.

Добавление небольшого шума на изображение панды слева «превращает» её в гиббона.

Кто виноват и как поступать

В 2016 году администрация Обамы получила отчет, в котором предупреждали от потенциальном применении дискриминации в решениях, принимаемых автоматически. Этот отчет также затрагивал вопрос создания алгоритмов, которые должны действовать в соответствии с принципами равных возможностей.

Легче сказать, чем сделать!

Во-первых, математические модели машинного обучения трудно тестировать и ремонтировать. Обычные программы мы оцениваем шаг за шагом, и мы знаем, как их тестировать, в случае машинного обучения всё зависит от размеров образца данных для обучения, который не может быть бесконечным.

Например, приложение Google Photo, используемое для распознавания и определения людей, определило чернокожих людей как горилл. Серьёзно! Как нетрудно предугадать, это вызвало скандал, а Google обещал исправить алгоритм. Однако, после трёх лет компании не удалось ничего улучшить, так что она просто запретила алгоритму определять какие-либо объекты на изображениях, как горилл, шимпанзе или обезьян.

Во-вторых, трудно понять и объяснить решения алгоритмов машинного обучения. Нейронная сеть размещает в себе весовые коэффициенты для получения правильных ответов, но как это происходит? И что вы можете сделать, чтобы изменить ответ?

Исследование 2015 года показало, что женщины значительно реже, чем мужчины, видят рекламу Google AdSense, предлагающую хорошо оплачиваемые должности. В свою очередь, предлагаемый компанией Amazon сервис доставки в тот же день часто не предоставляется в неблагополучных афро-американских районах. В обоих случаях представители компании не смогли объяснить решений, которые были приняты алгоритмами.

Так как в таких ситуациях трудно найти виновных, мы должны придумать новые правила и законы, которые должны выполнять роботы. В мае 2018 году в Германии впервые были приняты этические принципы, предназначенные для автономных автомобилей.

Среди них, в частности, следующие требования:

- Безопасность людей имеет более высокий приоритет, чем безопасность животных или повреждение предметов.

- Если событие является неизбежным, не может применяться дискриминации; не допускается использование факторов, дифференцирующих людей.

Но, что является для нас наиболее важным:

- Системы автоматического управления транспортными средствами станут этическим императивом, если будут вызывать меньше аварий, чем живые водители.

Очевидно, что мы всё больше и больше будем полагаться на машинное обучение, так как оно управляет многими задачами гораздо лучше, чем люди. Поэтому важно помнить об этих правилах и возможных проблемах, пытаться предвидеть все возможные проблемы на этапе создания и помнить о мониторинге эффективности алгоритмов, когда что-то работает не так, как должно.