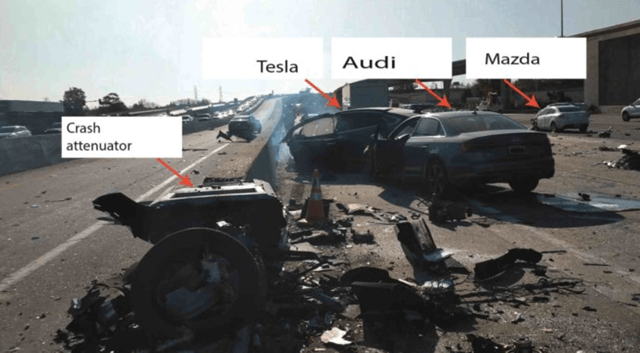

23 марта 2018 года случился, к сожалению, ещё одни смертельный несчастный случай с участием работающего в режиме автопилота автомобиля марки Tesla. Почти сразу после этого события многие начали задаваться вопросом: отвечает ли алгоритм за смерть человека?

Реконструкция аварии показала, что как система автопилота Tesla, так и встроенная в автомобиль система автоматического торможения вышли из строя. Непосредственно перед катастрофой автомобиль превысил местное ограничение скорости и направился в сторону бетонного барьера. Значит ли это, что виновато было программное обеспечение автомобиля?

Известно, что водитель не держал рук на рулевом колесе в момент аварии. Барьер, в который врезался автомобиль марки Tesla, уже до аварии была поврежден в результате предыдущей аварии, а дорога, на которой произошло описываемое событие, была в плохом состоянии.

Неразвитый алгоритм? Чистая случайность? Элон Маск и отдел маркетинга Tesla, кажется, представляют встроенные автономные системы вождения более совершенные и интеллектуальные, чем они есть на самом деле. Автономия может хорошо смотреться на проспектах инвесторов, но когда случаются ошибки, некоторые люди платят за это самую высокую цену.

Кто понесет вину, когда что-то пойдет не так

Как ни парадоксально, максимальная алгоритмизация транспорта не улучшит ситуацию. Да, автономные автомобили являются неотъемлемой частью видения мира, в котором любые дорожно-транспортные происшествия остались бы в прошлом, но одни только алгоритмы не решат проблему. Даже если большинство транспортных средств на дороге будут автономны, навыки оценки элементов дорожной инфраструктуры все равно будут важны, а водитель-человек в такой системе становится элементом хаоса, часто непредсказуемым.

Когда ИИ достигнет IQ 100 или 150, проблем не будет. Но когда это будет тысяча или 10 тысяч, что тогда? Это может быть величайшее достижение человечества. Но, в то же время его конец!

Стивен Хокинг

Впрочем, сам код тоже, в каком-то смысле, непредсказуем. Любое программное обеспечение всегда скрывает неисправность. Не в функциональном смысле, речь идёт, скорее, о том, что трудно полностью исключить ошибки в созданном коде. Ошибка может дать о себе знать в самый неожиданный момент, и чем больше общество будет зависеть от алгоритмов, тем больше будут последствия таких ошибок.

Даже если предположить гипотетически, что системы работают правильно, вы по-прежнему можете получить не предусмотренные разработчиком или самопрограммируемым искусственным интеллектом переплетения событий или взаимодействия. Интеллектуальное программное обеспечение может работать правильно, делая правильные выводы, которые, тем не менее, оказываются, по существу, неправильными из-за ошибочных или противоречивых данных. Кто же несет ответственность за аварию? Производитель? Программист? Или, может быть, алгоритм?

Искусственный интеллект – потенциально большая угроза для человечества, чем атомные бомбы.

Элон Маск

По определению, алгоритмы должны были упростить нашу жизнь. В большинстве случаев так и есть. Алгоритмы позволяют автоматизировать процесс принятия решений или присвоение оценок. Если программа делает это независимо от вклада людей и в соответствии со своими собственными измерениями, её обычно называют интеллектуальной или просто «искусственным интеллектом».

Однако, есть и другая сторона медали. Алгоритмы, независимо от того, определяем мы их как интеллектуальные или нет, становятся не только инструментом, посредством которого реализуется человеческая воля. Увеличивающаяся скорость их работы и растущая автономность приводят к тому, что алгоритмы вместо решения создают целые категории совершенно новых проблем, проверяя традиционные концепции вины, наказания или ответственности.

Таким образом, такие инциденты, как авария с Tesla, и, прежде всего, последующие горячие дискуссии на эту тему в СМИ, чрезвычайно важны. Здесь, как общество, мы сталкиваемся с совершенно новым классом проблем, вызванных современными технологиями.

Парадокс в том, что мы не можем решить эти проблемы технически, автоматически. Всё большая вычислительная мощность, объёмы памяти, скорости обработки – ничего не изменят, наоборот, они могут только углубить разрыв.

Алгоритм человеческого судьи

Алгоритмы всё чаще формируют нашу жизнь. Часто мы даже не замечаем как сильно. Они определяют, сможем ли мы и на каких условиях получить кредит, какие сообщения надо сначала посмотреть в интернете и стоит ли их нам показывать, с кем нам нужно встретиться и поговорить, а с кем лучше пойти на свидание.

Алгоритмизация – как может показаться на первый взгляд – это стратегия Святого Грааля. Алгоритмы помогают планировать войны и бои, независимо от того, думаем ли мы о них в метафорическом выражении, либо имеем в виду буквальные конфликты.

Код, выполняемый в современном цифровом мире, формирует наш взгляд на этот мир, влияет на наши дружеские отношения и карьеру. И горе нам, если мы совершаем ошибки, нарушим рецепт, заболеем или потеряем имущество. Алгоритмы говорят и принимают далеко идущие решения, касающиеся нашей жизни: «не подходит для работы», «незастрахован», «риск рецидива», «не имеет права на кредит» и т.д.

Заранее предполагается, что программы, которые могут обрабатывать данные в несколько раз быстрее, чем люди, являются непогрешимыми. Считается, что оценки, выданные алгоритмом, абсолютно верны. Так ли это? Дилетант, даже при полной прозрачности кода алгоритма, например, решающего о выдачи кредита или оценивающего квалификацию потенциальных сотрудников, не в состоянии сделать вывод правилен ли код, а оценка правдива и справедлива.

Проблема, однако, усугубляется тем, что большинство коммерческих алгоритмов де-факто классифицирующие людей, являются закрытыми.

То, каким образом и на основании каких данных, алгоритмы принимают решения, часто представляет собой тайное знание избранных корпораций. Что ещё хуже, механизм принятия решений бывает так сложен, что иногда становится непонятным даже для посвященных.

Решения искусственного интеллекта трудно понять. Многие ошибки могут появиться внезапно, без цели, а «жертва» часто определяется случайно. Кто следит за алгоритмами и отвечает за них, когда они совершают ошибку? Государство? Какая-то ассоциация?

Идея «умного черного ящика», который является продвинутым, саморазвивающимся искусственным интеллектом, действие которого перестают понимать даже его создатели (точнее – создатели первой итерации), который даёт приемлемые результаты без обоснования, как он добился этих результатов, вешает петлю на шею свободной воли.

Андерс Сандберг, ученый из Оксфордского университета, работающий в знаменитом британском университете «Институт Будущего Человечества», отмечает, что глубокие нейронные сети могут действительно хорошо работать, но они также могут совершать впечатляющие ошибки. Пора людям понять, что они не могут слепо доверять таким технологиям, как автономные транспортные средства или автономные медицинские системы.

Развитие самостоятельного искусственного интеллекта может означать конец человеческой расы.

Стивен Хокинг в интервью BBC, декабрь 2016

Тех, кто думает, что передовые алгоритмы искусственного интеллекта сегодня слишком слабы, чтобы они представляли проблему, я должен предупредить, что они сильно ошибаются. С алгоритмами проблема заключается в том, что им не нужно быть особо умными или особо сложными, но проблема все равно может возникнуть.

Это испытали граждане Австралии, которые получали социальные пособия. Правительство страны реализовало в июле 2016 года информационную систему, которая должна был самостоятельно, без участия человека, определить, имеет ли человек право на льготы. В случае расхождения система автоматически посылал запрос на баланс счета, а когда сталкивалась с отказом, передавала процедуру в систему коллекторов.

Как оказалось, система работала плохо, и в течение одной лишь недели сгенерировала около 20 тысяч вмешательств. Столько же, сколько выявили обычные чиновники за целый год. Десятки тысяч людей получили ложное предупреждение. Последующее расследование показало, что проблемы не было бы, если бы весь проект лучше планировался, осуществлялся и был доведен до сведения заинтересованных сторон.

Через несколько месяцев после неудачной отправки уведомления о взыскании задолженности были отменены. Конечно, каждая ошибка может быть исправлена, но ущерб общественному доверию к этим решениям был нанесен.

Утверждение, что интеллектуальные алгоритмы всё чаще вмешиваются в нашу жизнь – это трюизм. Очевидно, что чем дальше будет развиваться цифровое общество, тем больше будет точек привязки для автоматизации процессов в социальных, экономических и любых других сферах.

Искусственный интеллект оценивает нас, анализирует наше поведение, помнит наши привычки, принимает решения для нас и за нас, изменяя таким образом как общественную сферу, так и приватную. В том, как эффективно он может это делать каждый день, могут убедиться жители Китая: Как Китай оценивает граждан.

Прекрасный новый мир – правда?

Разработка ИИ скрывает обещание быстрого и более эффективного, удобного мира. Нужно помнить, что не только бизнес-модели, но и социальные модели всё больше зависят от таких технологий, как искусственный интеллект, интеллектуальные города, индустрия 4.0, IoT (Интернет вещей) и т.д. Всё, что можно автоматизировать, должно быть автоматизированным. Но всегда ли алгоритмические решения лучше? Наука доказывает, что нет. Имманентная особенность каждого разумного существа – совершать ошибки. Поэтому, после первоначального цунами технологий, пришло время задуматься о более глубоком значении и обоснованности цифровизации.

Нет сомнений в том, что алгоритмы помогли нам справиться с несколькими проблемами за гораздо меньшее время, чем мы потратили бы сами. К сожалению, алгоритмы создают и новые проблемы. Как элементы, принадлежащие к миру кода, они подвержены ошибкам. По скорости вычислений могут значительно ускорить человеческие ошибки и мгновенно внедрять в жизнь предрассудки и стереотипы своих программистов и тренеров нейронных сетей.

Правда, понимание ответственности и рисков, связанных с автоматизацией, постепенно приходит, но слишком медленно.

В этом процессе важно проанализировать эти новые типы проблем и их взаимодействие в алгоритмически ускоренном мире. Только те, кто понимает работу алгоритмов, могут увеличить их преимущества и уменьшить их вредный потенциал.

Особенно важным представляется проблема отсутствия нейтральности. Алгоритмы обычно не являются нейтральными инструментами. Кто-то их ведь создал, и, таким образом, они часто отражают убеждения своих создателей. В случае алгоритмов типа «интеллектуальный агент», мы имеем дело с отражением предрассудков, содержащихся в данных, на которых обучалась нейронная сеть.

Эта проблема проявляется по-разному. В коде многих искусственных интеллектов проявляется расизм, сексизм и другие социально-негативные явления. Пример? Вот, пожалуйста: в 2015 году Amazon обнаружили, что созданный корпорацией алгоритм покровительствовал мужчинам при поиске подходящих кандидатов. Не потому, что мужчины были объективно более подходящими кандидатами, а только потому, что алгоритм был обучен предыдущими данными, собранными сотрудниками отдела кадров, которые предпочитают мужчин.

Amazon обнаружил проблему, потому что им нужны были хорошие сотрудники, а выбор алгоритма сужал список потенциальных кандидатов. В результате система была пересмотрена, хотя сомнений по-прежнему осталось столько, что программа была закрыта в конце 2017 года.

Вопрос этики алгоритмов особенно остро обсуждается в Соединенных Штатах. Активисты за гражданские права всё чаще обнаруживают расистские предрассудки в якобы нейтральных алгоритмах оценки людей. Например, в американской системе правосудия вероятность, что человек будет снова арестован или обвинён в преступлении, рассчитывается по данным различных алгоритмов, анализирующих, в частности, степень контроля, времени заключения, и много других данных.

В результате алгоритм отражает расистские предрассудки, которые характеризуют исторические данные правоохранительных органов. Люди с другим цветом кожи, кроме белого, получают от машины более плохие отметки. Таким образом, исторический расизм лёг в основу современного и якобы нейтрального кодекса. Такая обратная связь от алгоритма к обществу и обратно к алгоритму является большой проблемой.

Настоящие проблемы только впереди

Всё, что мы уже упомянули, даёт представление о современном образе мира. Однако, реальной проблемой может быть боевой искусственный интеллект, даже не столько предназначенный для явного военного использования, сколько код, способный выполнять автоматические атаки в кибермире.

В конце концов, мы десятилетиями боролись с вредоносными программами, но киберпреступники также учатся использовать искусственный интеллект. Искусственный интеллект теперь может «понимать» речь, а также генерировать звуки, которые люди будут понимать как речь другого человека (см. Google Duplex).

Представьте себе, фишинговую атаку, направленную на конкретного человека. Искусственный интеллект собирает полезную информацию о своих целях, подражает реальным людям посредством синтеза речи и т.д. Аналогично, мы можем представить атаки, осуществляемые с использованием скоординированных, но автономных групп беспилотников, атаки на автономные транспортные средства (вымогательство), или создание целенаправленной пропаганды в качестве плацдарма для еще более сложных нападений, использующих социальную инженерию, и способных манипулировать общественным мнением всей общины.

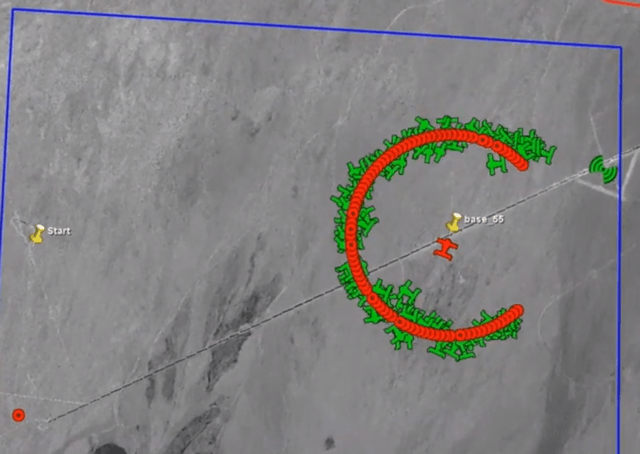

Мы также не можем пройти мимо другого аспекта – то есть, угрозы со стороны ИИ, самостоятельно принимающего военные решения. Например, армия США уже в прошлом году тестировала рой автономных беспилотников. В рамках работы над новым типом оружия, проходят испытания небольших независимых беспилотников. Сотня устройств может самостоятельно сформировать рой и перейти к боевым действиям. Проект носит название perdix, то есть «саранча». Неужели мы хотим, чтобы создатель алгоритма решал, как поведёт себя в будущем такой рой. А что произойдет, если вооруженный рой выйдет из-под контроля. Кто за это ответит?

Подводя итог, нетрудно согласиться с тем, что разработка интеллектуальных алгоритмов требует тщательного планирования, мониторинга, анализа и любых действий, которые могли бы нивелировать ошибки работающей системы.

К сожалению, опасения, что нам не удастся обнаружить все ошибки, являются вполне обоснованными. Поэтому, когда мы осознаем, что и люди, и алгоритмы подвержены ошибкам, возникает вопрос: сколько автономии и ответственности мы хотим оставить себе и сколько передать машинам?